本文目录一览:

学hadoop需要什么基础?

因此,学习hadoop必须掌握scala或者j***a中的一门开发语言,然后在学习hadoop数据操作命令,api,spark/map-reduce分析技术。另外,还可以学习hbase这种基于hdfs的结构化大数据存储技术,和flume大数据***集技术。

如果是掌握hadoop的使用,j***a基础好就可以了,看看hadoop权威指南。想深入学习源码的话,就需要些网络编程的知识了。

最好是有J***a基础,因为hadoop是用j***a编写的,所以懂j***a能够帮助理解hadoop原理,当然Hadoop也提供了其他语言的api。

需要。原因如下:大数据支持很多开发语言,但企业用的最多的还是j***a,所以并不是完全需要,有其它语言基础也可以,同时hadoop是由j***a编写的,要想深入学习,学习j***a是有必要的。

首先,不管你之前有没有接触过hadoop,或者你在某个方向特别牛逼,你都要有空杯心态,这才是学习的根据。

hadoop是怎么存储大数据的

在Hadoop中,数据存储有以下几种: HDFS:Hadoop分布式文件系统,以高容错性来存储海量数据。 HBase:分布式键值存储系统,可以在Hadoop平台上快速查询和检索数据。

Hadoop中有很多方法可以加入多个数据集。MapReduce提供了Map端和Reduce端的数据连接。这些连接是非平凡的连接,并且可能会是非常昂贵的操作。Pig和Hive也具有同等的能力来申请连接到多个数据集。

Hadoop:Hadoop是处理大数据的一个开源软件框架,它包括HDFS(分布式文件系统)和MapReduce(分布式计算框架)两个核心组件。HDFS用于存储和管理大规模数据集,具有高容错性和可扩展性。

大数据存储:Hadoop可以将大数据以分布式的方式存储在多个节点上,保证数据的安全性和可靠性。Hadoop使用Hadoop Distributed File System(HDFS)来存储数据,HDFS将数据划分为多个块并分散存储在多个节点上。

“大数据”是松散的数据***,海量数据的不断增长迫使企业需要通过一种新的方式去管理。大数据是结构化或非结构化的多种数据类型的大***。

下列哪些是hadoop中的数据存储

1、以下选项中NameNode程序负责hdfs数据存储。根据查询相关信息显示,在Hadoop中,HDFS的数据存储是由NameNode程序负责的。NameNode程序是HDFS的主要组件之一,它管理文件系统的命名空间和客户端对文件的访问。

2、负责“hdfs”和“数据存储”的程序是HDFS。Hadoop分布式文件系统(HDFS)被设计成适合运行在通用硬件(commodityhardware)上的分布式文件系统。它和现有的分布式文件系统有很多共同点。

3、JobClient会在用户端通过JobClient类将应用已经配置参数打包成jar文件存储到hdfs,并把路径提交到Jo***racker, 然后由Jo***racker创建每一个Task(即MapTask和ReduceTask)并将它们分发到各个TaskTracker服务中去执行。

hadoop三大核心组件

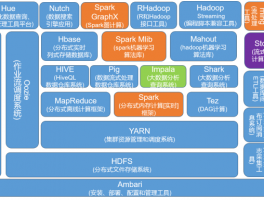

hadoop三大组件是指Hadoop分布式文件系统、MapReduce和Yet Another Resource Negotiator。HDFS:Hadoop分布式文件系统是Hadoop的分布式文件系统,它是将大规模数据分散存储在多个节点上的基础。

Hadoop的三大核心组件是HDFS(Hadoop Distributed File System)、MapReduce和YARN(Yet Another Resource Negotiator)。虽然Hadoop主要用于分布式数据处理,但这些组件也提供了文件的查找和访问功能。

(2)Hadoop的核心是MapReduce(映射和化简编程模型)引擎,Map意为将单个任务分解为多个,而Reduce则意为将分解后的多任务结果汇总,该引擎由Jo***rackers(工作追踪,对应命名节点)和TaskTrackers(任务追踪,对应数据节点)组成。