谷歌大脑发布概念激活向量,了解神经网络的思维方式

概念的CAV就是一组该概念的实例在不同方向的值(例如,激活)构成的向量。在论文中,Google研究团队概述了一种名为Testing with CAV(TCAV)的线性可解释方法,该方法使用偏导数来量化预测CAV表示的潜在高级概念的敏感度。

谷歌研究员杰夫·辛顿(Geoff Hinton)正致力于开发所谓的“思想向量”(thought vector),其功能是提取一个句子的意思,从而使其可与其他句子或图像进行对比。这种概念为谷歌新的Q&A项目提供了支持。

深度学习算法有哪些深度学习常见的3种算法有:卷积神经网络、循环神经网络、生成对抗网络。

人工神经网络的概念; 人工神经网络的发展历史; 人工神经网络的特点; 人工神经网络的结构。 。

同时,他还曾在Google公司的“谷歌大脑”项目中担当要职,帮助谷歌建立全球最大的“神经网络”,这个神经网络能以与人类大脑学习新事物相同的方式学习现实生活。2014年,Andrew加入百度担任百度首席科学家。

年前后,随着计算能力的提升和大数据的涌现,以神经网络为基础的“深度学习”崛起,科技巨头公司谷歌、Facebook、百度投入巨资研发,神经网络迎来第三次***[1]。

谷歌大数据三篇论文什么时候发表的

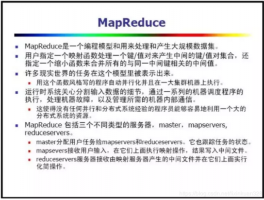

1、今天我们常说的大数据技术,其实起源于Google在2004年前后发表的三篇论文,也就是我们经常听到的“三驾马车”,分别是分布式文件系统GFS、大数据分布式计算框架MapReduce和NoSQL数据库系统BigTable。

2、Google于03至06年左右公布了三篇论文,描述了GFS、BigTable、MapReduce三种技术以解决这些问题。

3、现在炙手可热的大数据技术,起源就是谷歌的三篇技术论文。2003年谷歌公布了有关谷歌文件系统(Google File System)的第一篇论文,阐述了分布式文件系统:文件被分割成很多块,使用冗余的方式储存于机器集群上。这就是大数据文件系统的原型。

4、但自从2004年Google发布关于GFS,MapReduce和BigTable三篇技术论文之后,云计算开始兴起,2006年Apache Hadoop项目启动。随后从2009年开始,随着云计算和大数据的发展,Hadoop作为一种优秀的数据分析、处理解决方案,开始受到许多 IT企业的关注。

5、存储技术、感知技术的发展,阐述大数据从***集、处理、存储到形成结果的全过程。实践是大数据的终极价值。在这里,我们从互联网大数据、***大数据、企业大数据、个人大数据四个方面来描绘大数据的美好图景和将要实现的蓝图。

6、先前4月8日,这篇数十位国内AI大神参加论文被指比较严重抄袭,NicholasCarlini公布发文,控告一篇于2022年3月26日发表在论文预印网址Arxiv的论文《关于“大模型”的路线图》(ARoadmapforBigModel)一文因涉嫌比较严重抄袭。

谷歌学术论文他引150次什么水平

1、算。谷歌学术引用量是衡量一篇学术论文影响力的重要指标之一。学术生涯引用破1500是非常多的。谷歌学术搜索是一个文献检索服务,主要是提供维普资讯、万方数据等几个学术文献***库的检索服务。

2、一般来说,学术文章的被引用次数在[40, 60]这个区间,算是比较合理的。如果被引用次数在[60, 100],那么这篇论文可能被引用次数已经算是非常高的了。

3、正常情况下,一般被引用10次以上,说明文章质量较高。特别是实验性论文,引用十次以上说明得到了行业内的认可。部分高水平论文,引用次数达到2000多次。

4、很高的水平。单纯从次数上看的确很厉害,不过要看该文是什么类型的文章,如果是原理创新型文章,那是水平很高。如果是测量实验类的文章则未必,因为这样该文章就是提供原始数据,大家因为都要用到该数据所以引用次数高。

5、他引累计大于1000水平高。他引率=(被其他刊引用的次数)除以(期刊被引用的总次数),论文他引率是引用他人的部分占全文的比重,因此他引累计大于1000水平高。水平,业务、生产、生活等各方面所达到的程度。

6、论文查重中他引率低于5%算正常,知网对于引用内容也设有一定的阈值5%,知网有且仅能剔除阈值5%范围内的引用内容,当引用内容超过章节总字符数的5%,知网机会将这些引用内容识别为论文正文进行数据查重。

从谷歌流感趋势谈大数据分析的光荣与陷阱

1、从谷歌流感趋势谈大数据分析的光荣与陷阱 本文从谷歌流感趋势2009年前后表现差异谈起,讨论了大数据分析容易面临的大数据自大、算法演化、看不见的动机导致数据生成机制变化等陷阱,以及对我国大数据产业发展的借鉴。

2、谷歌开发的名为“谷歌流感趋势”的工具,通过跟踪搜索关键词频率来判断全美地区的流感情况,当关键词(如温度计、流感症状、肌肉疼痛、胸闷等)搜索率飙升时,工具便会发出预警。

3、“预测即干涉”的问题。类似于物理学中的“测不准原理”,在大数据分析中,预测和实际结果之间也会存在无法避免的误差。因为一旦进行预测,就会对结果产生影响,而这个影响是无法精确控制的。